[LLM] 온디바이스 AI 탑재 방법? (정리중)

스마트폰에 LLM 넣는법?

VIVO, samsung, LG 사례 찾아보기

AppAgent: 자율 탐색을 통해, 혹은 사람의 데모를 관찰하여 새로운 앱을 탐색하는 방법 학습. 여러 앱에서 복잡한 작업 실행 시 참조하는 지식 기반 생성.

LLM의 맥락에서, 이 연구는 텍스트 전용 처리에서 이제 에이전트가 텍스트와 시각적 정보를 모두 이해하고 그에 따라 행동할 수 있는 멀티모달 인터랙션으로의 전환을 강조. 운영체제의 스크린샷 해석 등... 시각적 단서를 바탕으로 정보에 입각한 결정 가능 -> 백엔드 액세스 없이 작동하는 에이전트의 기능은 다양한 스마트폰 앱에서 사용 가능.

삼성전자 갤럭시AI

https://www.newspim.com/news/view/20240119000974

LLM 경량화. 삼성전자 MX사업부 언어AI팀장.

- 갤럭시AI: 음성인식, 번역, 음성합성, 거대언어모델 6개의 기술. 특히 모바일은 활용가능한 메모리 한계. 학습 시 Pruning, fine tuning 필요한데 이때 파라미터 수도 많아짐. 필요한 부분에 특화된 형태(how? -> )로 개발하며 동시에 성능저하 없도록?

- 실시간 통화 통역에서도 이 경량화 기술 활용. 기존 음성인식 AI 모델이 간단 명력어 인식수준에 집중했다면, 일상생활에서 사용자들이 말하는 것을 모두 인식 가능하도록. 언어모델 학습 방식도 언어별로 나누지 않고 구분없이 학습 후 필요없는 기능 제거하는 파인튜닝으로 경량화 했음.

- 네트워크 없이도 번역서비스 이용하게 하는게 핵심

- 사용자 중심의 맞춤형 폰인데 사용자 패턴 학습을 안한다? 양날의 검. 안전 보장하면서 개인만의 기능을 구현하기 위한 기술은 아직 개발중..

- 할루시네이션 방지 위해 세이프필터, 세이프가드

- AI기능 온오프 가능.

메르세데스-벤츠

- 생성형 AI기반 차량내 음성비서 강화. 보다 자연스러운 상호작용과 개인화된 운전자경험을 위한 길 닦음. ex) 차량 탑승 시 아침 뉴스 헤드라인 재생, 약속에 늦은 것이 확인되면 대상에게 늦는다는 전화를 제안하는 등..

- chatGPT, 기타LLM들은 여전히 정확하지 않아서... openAI말고 다른회사와 협력.

- 음성비서: 자연스러운 대화와 고객 질문에 대한 답 찾기위해 LLM에 의존. 자연성, 예측성, 개인성, 공감성. 어투도 다르게..

- 운전자가 도로에 계속 집주할 수 있게하는 첨단기술?

"Voice assistants in the automotive industry are set to become an even more integral part of all vehicular systems, extending beyond their current roles in climate, entertainment, and navigation to include advanced safety mechanisms. Leveraging complex AI algorithms, these next-gen voice assistants will have the capability to discern context and mood while also proactively providing recommendations based on real-time information and historical user data," he predicts.

"Microphones throughout the cabin, coupled with profile recognition technology, will enable the voice assistant to identify individual speakers and offer a personalized in-car experience." .

"Benefiting from advancements in large language models, these systems will achieve a more natural, conversational tone, thereby minimizing intrusion and enhancing the user experience. Moreover, tight integration with Advanced Driver-Assistance Systems (ADAS) will enable the voice assistant to issue immediate safety alerts and recommendations," concludes Schmitt.

TESLA

라이다x, 레이다,사진

BMW

https://www.aitimes.com/news/articleView.html?idxno=123438

[포토] AI(인공지능) 음성인식 자동차 BMW 인텔리전트 퍼스널 어시스턴트 - AI타임스

(AI타임스=전승진 기자) BMW는 사용자의 말을 알아듣고 선호도를 학습할 수 있는 BMW 인텔리전트 퍼스널 어시스턴트(BMW Intelligent Personal Assistant)를 내놓았다. 운전자가 음성으로 차량 설정을 컨트롤

www.aitimes.com

BMW 인텔리전트 퍼스널 어시스턴트는 사용자의 모든 명령, 질문 및 설정을 기억하고 학습한다. 이러한 AI기술이 적용된 자동차는 몇 개월만 타고 다녀도 동일 모델의 다른 차량과는 달리 사용자를 위한 차량이 된다. 또한 계정(ID)에 정보가 저장이 되며 다른 사람의 BMW에 사용자의 ID를 입력하면 사용자의 설정대로 세팅이 된다.

안녕, 배고파! 하면 주변 레스토랑 찾아줌. 시트히터 활성화 혹은 좋아하는 음악 재생. (니즈르 학습하고 기억). 습관 자동화. 특정 상황에서 자주 사용하는 기능을 습관으로 저장. 선호도를 학습.

amazon alexa LLM 활용.

MoE

Hallucination, 높은 매개변수에 수반되는 학습비용 해결하기 위해 RAG, Mixtral 등 새로운 AI방법론 등장.

GPT-4

Mixtral: 1000억 개 가량의 매개변수가 넘어가는 모델이 아니라도, MoE방식을 활용해 도메인 학습이 가능한 소규모 언어모델

RAG

RAG는 Wikipedia, News 등 LLM의 학습 내용 외에도 외부로부터 디테일한 소스를 불러올 수 있다. 이는 LLM의 Hallucination Rate 감소에도 큰 역할을 할 뿐 아니라, 추가 Fine Tuning의 과정 없이도 최신 데이터 제공이 가능하고, 구동 코드 또한 간단하다는 장점을 가지고 있음

Mixtral

GPT보다 작지만 더 똑똑.

- MoE는 대형언어모델(LLM)을 생물, 물리, 수학 등 각 분야를 담당하는 작은 전문 모델(Expert) 로쪼개고,프롬프트에따라전문모델을연결하거나몇종류를섞는방식으로전체큰모델을돌리는것보다비용과시간이훨씬적게소모. 모든계 층, 모든 토큰에 대해 라우터(경로설정) 네트워크는 토큰을 처리하고 출력을 추가로 결합하기 위해 프롬프트에 가장 적합한 전문가그룹을 선별.

OnDevice AI

NPU 칩 중요.(Neural network Processing Unit) -> 서버와 통신 없이 소모 전력을 적게 들이며 AI이용가능.

애플: 제한된 메모리로 효율적인 대규모 언어 모델을 추론하는 법(Efficient Large Language Model Inference with Limited Memory)’입니다. 이는 메모리가 제한된 기기에 LLM을 구축하는 기술입니다. 연구진은 이 방법을 활용해 애플 M1 맥스 CPU(Central Processing Unit, 컴퓨터 시스템을 통제하고 프로그램의 연산을 실행, 처리하는 가장 핵심적인 컴퓨터 제어 장치 혹은 그 기능을 내장한 칩)에서 추론 시간을 4~5배 앞당기고, 속도는 20~25배까지 향상할 수 있다고 설명했습니다.

LG: DAP GenAI: 내부정보만 활용. 보안필터활용. 할루시네이션 감소. , 넷츠프레소: 성능 저하를 최소화해 스마트폰과 소형 IoT 기기에서 독립적으로 AI를 구동

온디바이스 AI칩.. 실제로 어떻게 올리냐고 ㅠ ㅠ 스마트카에서 활용가능. LG8111

퀄컴 : 퀄컴 칩이 장착된 디바이스에서, 2023년 메타의 라마2 압축모델 구동 기술 시연

https://brunch.co.kr/@choseunghyek/4

MobileBERT: knowledge transfer. (distillation). 전이.. 구조는 거의 똑같되 각 레이어의 크기만 다르게.

각 transformer에서 나오는 feature map들이 가장 의미있는 정보를 가지고 있음. 얘네를 줄일 수 있을만큼 줄여야 함.

- Bottleneck

- Embedding(임베딩 차원을 1024->128)

- Stacked FFNs: MHA, stacked FFN의 파라미터 수 비율이 0.4~0.6이 되게 맞추는 것.. 비율이 중요

- LayerNorm/GeLU: Layer Normalization, activation이 inference 많이 잡아먹는다고 생각하여 layernorm 제외, gelu->relu

Transformer의 아웃풋: feature map. 이것을 어떻게 전이? output 차원을 동일하게 만들고, student 모델이 teacher 모델과 똑같은 피쳐맵을 가지도록 학습하ㄴ여 서로의 아웃풋이 MSE loss를 줄이도록.

+Self-Attention: head수는 동일하므로 전이가 쉬움. KL divergence 최소화하도록.

+Distillation:(정제): 기존 BERT pretraining 방법인 MLM, NLPfmf knowledge transfer가 끝난 mobileBERT에 적용하는 것. loss를 줄이는 방식으로..

퀄컴에서 llama2 까지 구동 가능하게! 그럼 cost낮아지니까 언어모델 올리기 좋다. 누군가 매일, 매주 파인튜닝하면 됨.. 서버에서도 괜찮지만 온디바이스(스피커통해 음성입력-핸드폰 내 뉴럴엔진-스피커로 응답? cost줄어듦. 그래서 뉴럴엔진에 대한 서포트 올라감.

병렬프로그래밍 기초 MUTEX, SEMAPHORE, CUDA

Alpaca:

- 가장 작은 7B 모델은 이제 라즈베리파이/모바일 폰에서도 도는데, 매우 인상적인 결과를 뽑아내줌(아직 상업용은 아님)

- llama.cpp 는 LLM을 4GB 수준의 소비자 하드웨어에서 실행가능

- Alpaca는 52K의 예제와 $100의 비용으로도 7B 모델(4bit 양자화로 4GB로 줄인) 파인 튜닝이 가능하며, 최신 text-davinci-003 과 비슷한 결과를 낼수 있다는 것을 보여줌

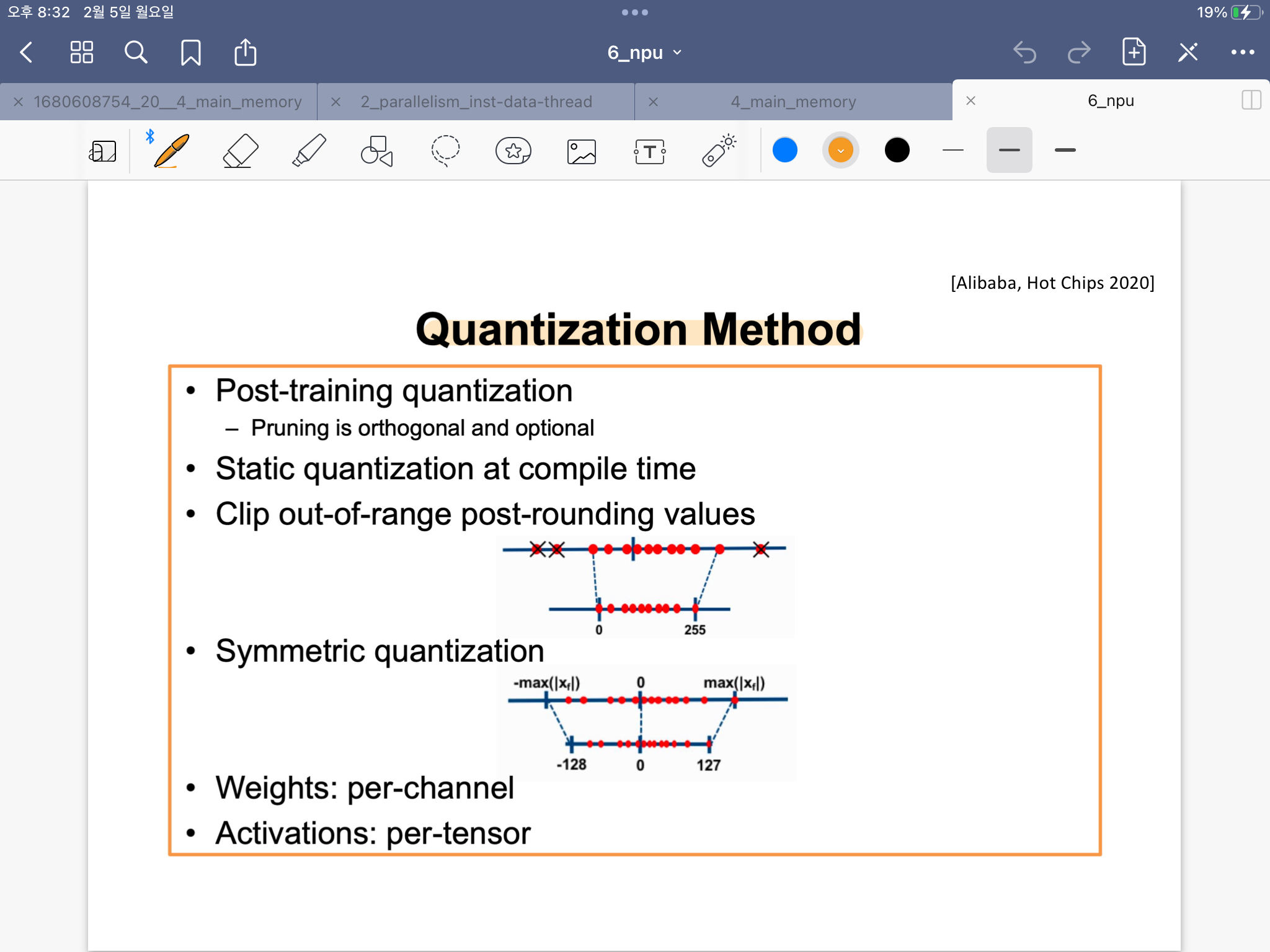

Quantization: 모델 압축을 통해 추론과정에서 발생하는 오버헤드 줄이는 방법. GPTQ(2023) .사후훈련 양자화.

OPT+PTQ=OPQ

결국 모델의 크기를 줄이면 된다..